Die KI-Revolution beschleunigt sich: Was ist wirklich neu?

Jeden Freitag das Gleiche: Neue KI-Ankündigungen überfluten deine Timeline. Doch welche Entwicklungen sind wirklich relevant für dein Business? Wir haben die wichtigsten News der Woche analysiert und zeigen dir, was hinter den Schlagzeilen steckt.

Die großen Player wie OpenAI, Meta und Google liefern sich ein Wettrennen um die leistungsfähigste KI. Gleichzeitig entstehen neue Plattformen für Enterprise-Kunden. Für Unternehmen stellt sich die entscheidende Frage: Wie nutze ich diese Innovationen, ohne mich an einen Anbieter zu binden?

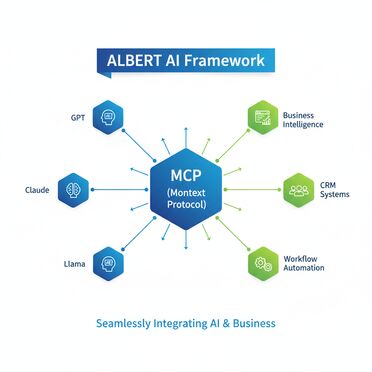

Die Antwort liefert ALBERT | AI mit seinem revolutionären Model Context Protocol. Aber der Reihe nach – schauen wir uns erst die verifizierten News der Woche an.

GPT-5 ist da: OpenAIs neues Modell mit verbessertem Reasoning

Was kann GPT-5 wirklich?

OpenAI hat GPT-5 offiziell vorgestellt. Das neue multimodale System kann verschiedene Datentypen wie Text, Code und Bilder verarbeiten. Laut OpenAI verfügt GPT-5 über erweiterte "Reasoning"-Fähigkeiten – das Modell kann tiefergehende Verarbeitungskomponenten einsetzen, wenn die Aufgabe es erfordert.

Die bestätigten Features im Überblick:

- Verbessertes Reasoning: GPT-5 setzt je nach Aufgabe unterschiedliche Verarbeitungstiefen ein

- Multimodale Integration: Verarbeitung von Text, Code und Bildern in einem System

- Automatische Antwortweise: Das Modell wählt selbst zwischen schnellen und tiefgehenden Antworten

- Erweiterte Coding-Fähigkeiten: Verbesserte Performance bei Programmieraufgaben laut OpenAI

- Standard in ChatGPT: GPT-5 wird das neue Standardmodell in ChatGPT

Was bedeutet das für Unternehmen?

GPT-5 ist zweifellos leistungsfähig. Die genauen Kosten und Performance-Metriken sind noch nicht öffentlich verfügbar. Hier kommt ALBERT | AI's MCP ins Spiel: Du kannst GPT-5 für komplexe Tasks nutzen und für einfache Aufgaben auf günstigere Modelle umschalten – automatisch und regelbasiert.

Meta Llama 4: Open-Weight-Modelle mit Multimodalität

Die Llama 4 Familie im Detail

Meta hat die Llama 4 Serie offiziell veröffentlicht. Bestätigt sind zwei Hauptmodelle:

- Llama 4 Scout: Ein effizientes Modell mit einem außergewöhnlich großen Kontextfenster von bis zu 10 Millionen Token (laut Cloudflare)

- Llama 4 Maverick: Ein leistungsfähiges Modell für Business-Anwendungen

Meta bewirbt Llama 4 als multimodales System mit Text- und Bildverarbeitung. Die Modelle sind unter einer Open-Weight-Lizenz verfügbar (mit bestimmten Einschränkungen für kommerzielle Nutzung).

Hinweis: Ein drittes Modell namens "Behemoth" wurde von Meta angekündigt, ist aber laut aktuellen Quellen noch nicht vollständig veröffentlicht.

Der Vorteil von Open-Weight-Modellen

Im Gegensatz zu proprietären Modellen kannst du Llama 4 auf eigener Hardware betreiben. Das bedeutet volle Datenkontrolle und keine laufenden API-Kosten. ALBERT | AI Agenten können Llama 4 lokal nutzen – perfekt für sensible Unternehmensdaten, die das Haus nicht verlassen dürfen.

Google Gemini 2.5: Speed trifft auf Intelligenz

Die Gemini Evolution

Google hat Gemini 2.5 eingeführt. Die neue Generation kommt in mehreren Varianten:

- Gemini 2.5 Flash-Lite: Optimiert für Geschwindigkeit und Kosteneffizienz

- Gemini 2.5 Pro: Der ausgewogene Mix für Produktivanwendungen

- Gemini 2.5 Ultra: Maximum Performance (in Entwicklung)

Laut Google verfügen die Gemini 2.5 Modelle über verbesserte Reasoning-Fähigkeiten: Sie können ihre Gedankengänge durchdenken, bevor sie antworten, was zu verbesserter Performance und höherer Genauigkeit führt.

Integration in Google Workspace

Der wahre Trumpf von Gemini liegt in der nahtlosen Google-Integration. Von Gmail über Docs bis zu Sheets – überall arbeitet KI mit. Für Unternehmen mit Google Workspace ist das verlockend. Aber Vorsicht: Der Vendor Lock-in ist real. Mit ALBERT | AI's MCP bleibst du flexibel und kannst Gemini nutzen, ohne dich zu binden.

Neue KI-Plattformen: Der Kampf um Enterprise-Kunden

Microsoft Azure AI Foundry: Die Enterprise-Plattform

Microsoft hat Azure AI Studio zu Azure AI Foundry weiterentwickelt. Die Plattform bietet laut Microsoft:

- Multimodale Input-Unterstützung und strukturierte Outputs

- Tool-Integration und Enterprise-fähige Features

- Integration in Microsoft 365 und Dynamics

- Enterprise-Grade Security mit Azure Active Directory

- Compliance-Features für EU AI Act und DSGVO

Der Haken? Die Komplexität. Ohne dediziertes AI-Team und Azure-Expertise wird's schwierig.

Databricks Lakehouse AI: Daten und KI verschmelzen

Databricks verfolgt einen Data-First AI Ansatz. Die Lakehouse-Architektur vereint Data Warehouse und Data Lake. Bestätigte Features:

- AutoML für automatisierte Modellentwicklung

- Feature Store für wiederverwendbare Datenfeatures

- MLflow für Modell-Lifecycle-Management

- Unity Catalog für Data Governance

- Integration von MosaicML für generative KI

Warum ALBERT | AI die praktische Alternative ist

Während Azure und Databricks auf Komplexität setzen, macht ALBERT | AI es einfach. Das Model Context Protocol abstrahiert die Komplexität. Du arbeitest mit einer einheitlichen Schnittstelle – egal ob GPT-5, Llama 4 oder Gemini.

Der Clou: ALBERT | AI ist keine Insellösung. Es integriert sich nahtlos in bestehende Systeme wie agorum core DMS, SAP oder Microsoft 365. Ohne Vendor Lock-in, ohne versteckte Kosten.

KI-Infrastruktur: Hardware und Software optimiert

NVIDIA's Fortschritte bei KI-Hardware

NVIDIA treibt die KI-Hardware-Entwicklung voran. Auf der SIGGRAPH 2025 präsentierte das Unternehmen:

- Neue kompakte Blackwell-GPUs für KI-Workloads

- Enterprise-Server mit optimierter KI-Performance

- DGX Spark Desktop-Systeme für Teams (ab Juli 2025 verfügbar)

- Fortschrittliche KI-Modelle für physische Simulationen

NVIDIA und OpenAI haben außerdem ein Joint Venture angekündigt, das mindestens 10 Gigawatt Rechenleistung in globalen KI-Rechenzentren bereitstellen soll.

Die Realität: Framework schlägt spezialisierte Systeme

Während die Industrie auf spezialisierte Hardware setzt, liefert ALBERT | AI bereits heute, was Unternehmen brauchen: Ein KI-Framework, das auf bestehender Infrastruktur läuft. Keine Hardware-Migration, keine Systemwechsel. ALBERT | AI funktioniert auf deiner vorhandenen IT – sofort einsatzbereit.

ALBERT | AI: Das praxiserprobte KI-Framework

Model Context Protocol: Der offene Standard

Das Model Context Protocol (MCP) ist ein offener Standard für die Integration und Kommunikation zwischen digitalen Tools, KI-Modellen und Unternehmensdaten. Es bietet:

- Einheitliche Tool-Integration: Alle gängigen KI-Modelle sprechen dieselbe Sprache

- Kontext-Management: Informationen bleiben über Modellwechsel hinweg erhalten

- Automatische Modellwahl: Je nach Task wird das optimale Modell gewählt

- Kostenoptimierung: Günstige Modelle für einfache, teure für komplexe Aufgaben

KI-Agenten in der Praxis

ALBERT | AI Agenten arbeiten autonom und erledigen konkrete Aufgaben:

- Rechnungsverarbeitung: Von der Erfassung über Prüfung bis zur Buchung

- Kundenservice: 24/7 Betreuung mit Zugriff auf relevante Systeme

- Dokumentenmanagement: Automatische Klassifizierung und Ablage

- Prozessoptimierung: Kontinuierliche Verbesserung durch Machine Learning

Compliance by Design

ALBERT | AI wurde von Grund auf für den europäischen Markt entwickelt:

- 100% Hosting in deutschen Rechenzentren

- Revisionssichere Dokumentation aller KI-Entscheidungen

- Automatische Einhaltung von EU AI Act

- Transparente Quellenangaben für Explainable AI

- Rollenbasierte Zugriffskontrolle

Häufig gestellte Fragen FAQ: Die wichtigsten Fragen zu den KI-News

-

Welche konkreten Verbesserungen bringt GPT-5?

GPT-5 ist laut OpenAI ein multimodales System mit verbessertem Reasoning. Es kann Text, Code und Bilder verarbeiten und wählt automatisch zwischen schnellen und tiefgehenden Antworten. Die genauen Performance-Metriken und Kosten sind noch nicht öffentlich verfügbar.

-

Kann ich Llama 4 wirklich kostenlos nutzen?

Ja, Llama 4 ist unter einer Open-Weight-Lizenz verfügbar und kann heruntergeladen werden. Es gibt jedoch Einschränkungen für die kommerzielle Nutzung. Du brauchst außerdem leistungsfähige Hardware - für größere Modelle sind erhebliche GPU-Ressourcen erforderlich.

-

Was ist das Model Context Protocol (MCP)?

Das MCP ist ein offener Standard von Anthropic und agorum, der eine einheitliche Schnittstelle für alle KI-Modelle und Tools bietet. Es ermöglicht die nahtlose Integration verschiedener KI-Systeme ohne Vendor Lock-in und ist bereits in ALBERT | AI implementiert.

-

Wie groß ist das Kontextfenster von Llama 4?

Llama 4 Scout verfügt laut Cloudflare über ein außergewöhnlich großes Kontextfenster von bis zu 10 Millionen Token. Das ermöglicht die Verarbeitung sehr umfangreicher Dokumente in einem Durchgang.

-

Welche Gemini-Modelle sind aktuell verfügbar?

Google bietet Gemini 2.5 in mehreren Varianten: Flash-Lite (optimiert für Geschwindigkeit), Pro (ausgewogen für Produktivanwendungen) und Ultra ist in Entwicklung. Alle Modelle verfügen über verbesserte Reasoning-Fähigkeiten.

-

Was kostet die Nutzung von Azure AI Foundry?

Microsoft hat keine pauschalen Preise veröffentlicht. Die Kosten hängen von vielen Faktoren ab: genutzten Modellen, Datenvolumen, Rechenzeit und zusätzlichen Services. Für eine genaue Kalkulation ist eine individuelle Beratung notwendig.

-

Kann ALBERT | AI mit den neuen Modellen arbeiten?

Ja! ALBERT | AI kann über das MCP flexibel verschiedene Modelle integrieren, darunter GPT-5, Llama 4 und Gemini. Du entscheidest, welches Modell für welchen Use Case zum Einsatz kommt - ohne dich an einen Anbieter zu binden.

-

Wie unterscheidet sich ALBERT | AI von großen Cloud-Plattformen?

ALBERT | AI fokussiert auf Einfachheit und Datensouveränität: 100% Hosting in Deutschland, transparente Preise ohne versteckte Kosten, sofort einsatzbereit ohne komplexe Konfiguration, und volle DSGVO-Compliance von Anfang an.

Fazit: Fakten statt Hype - Was zählt für dein Unternehmen

Die aktuellen KI-Entwicklungen sind beeindruckend: GPT-5 mit verbessertem Reasoning, Llama 4 mit riesigen Kontextfenstern, Gemini 2.5 mit durchdachten Denkprozessen. Aber für Unternehmen ist nicht das neueste Modell entscheidend, sondern die beste Integration in bestehende Prozesse.

Genau hier punktet ALBERT | AI:

- Flexibilität: Nutze alle verfügbaren Modelle – ohne Vendor Lock-in

- Einfachheit: Keine Komplexität, sofort einsatzbereit

- Compliance: DSGVO und EU AI Act von Anfang an

- Made in Germany: Deutscher Support, deutsche Server

- Transparenz: Klare Preise ohne versteckte Kosten

Deine nächsten Schritte

- Informiere dich über die ALBERT | AI Möglichkeiten

- Identifiziere konkrete Use Cases in deinem Unternehmen

- Lade das Whitepaper zur KI-Strategie herunter

- Vereinbare einen unverbindlichen Beratungstermin

Die KI-Entwicklung schreitet voran – mit ALBERT | AI bleibst du flexibel und zukunftssicher. Jeden Freitag gibt es hier die neuesten, verifizierten KI-News!

Quellen und weiterführende Links

- OpenAI - GPT-5 Announcement

- Meta Llama 4 - Official Site

- Cloudflare Blog - Llama 4 Scout Details

- Google Cloud AI - Gemini 2.5 Models

- Microsoft Azure AI Foundry

- Databricks Lakehouse AI

- ALBERT | AI - Die KI-Plattform für dein Unternehmen

- agorum core - Dokumentenmanagement mit KI

- Praxisbeispiele: KI erfolgreich einsetzen

- agorum® Academy - KI-Schulungen und Workshops